L'intelligenza artificiale si sta avvicinando stranamente ai dati di Star Trek: TNG ora che sa se ci si può fidare o meno

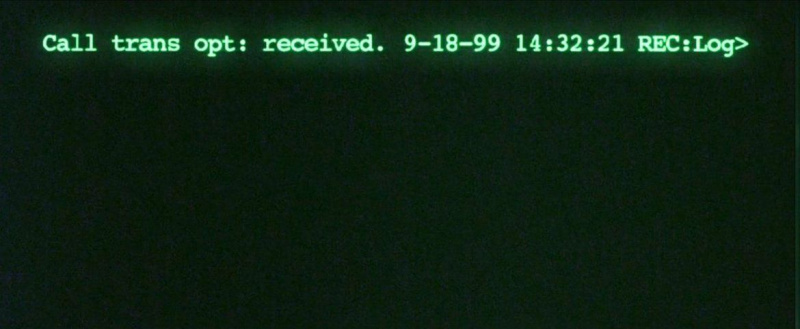

>Potrebbe non essere autoconsapevole come Data from Star Trek: TNG (ancora), soprattutto perché quel droide potrebbe prendersi cura di un gatto meglio di alcuni umani, ma l'intelligenza artificiale ora ha raggiunto il punto di rendersi conto quando non è affidabile.

Quello che ora si chiama profonda regressione probatoria ha aumentato l'autoconsapevolezza dell'IA. Saprà quando ha una maggiore possibilità di commettere un errore nella previsione, in base alla valutazione dell'affidabilità dei dati che sta esaminando. Le previsioni future hanno maggiori probabilità di funzionare se sono influenzate da dati più approfonditi e accurati. Il contrario significa che le cose probabilmente andranno male, e l'intelligenza artificiale lo può percepire. Quando stima la sua certezza su qualcosa, quella certezza aumenterà e diminuirà a seconda dei dati che riceve. L'intelligenza artificiale può quindi determinare il rischio o l'incertezza con una precisione del 99%.

anchorman 2: la leggenda continua

Sembra che anche Picard sarebbe impressionato, ma aspetta. C'è solo un inconveniente nei robot autocoscienti, ed è che il 99% non è una certezza completa, non importa quanto sia vicino. Un calo di appena l'1% potrebbe significare un disastro in scenari potenzialmente pericolosi per la vita, dalla guida di un'auto autonoma all'esecuzione di un intervento chirurgico. Allarmante.

Mentre [regressione probatoria profonda] presenta diversi vantaggi rispetto agli approcci esistenti, i suoi limiti principali sono nella regolazione del coefficiente di regolarizzazione e nella rimozione efficace di prove non fuorvianti durante la calibrazione dell'incertezza, detto MIT Ph.D. studente Alexander Amini , che ha condotto uno studio che presenterà alla conferenza NeurIPS del mese prossimo.

Quello che Amini e il suo team sono riusciti a fare è ancora piuttosto notevole. Prima di questo, l'utilizzo dell'intelligenza artificiale per stimare l'incertezza non era solo costoso, ma anche troppo lento per prendere decisioni che dovevano essere prese in frazioni di secondo. Le reti neurali possono essere così immense che possono volerci un'eternità per calcolare una risposta, e l'attesa per apprendere il livello di confidenza sarebbe troppo lunga anche per preoccuparsi di impegnarsi. Sarebbe inutile usare qualcosa di simile in un sé -guida di un'auto che ha bisogno di sapere subito quale svolta fare. Il processo è stato fatto avanzare velocemente da una profonda regressione probatoria. Questa rete neurale deve essere eseguita solo una volta per scoprire il livello di incertezza.

non andrà lontano a piedi

Indovinando l'incertezza in un modello che l'IA ha già appreso, può dirci approssimativamente quanto è ampio il margine di errore. L'IA utilizza le prove per sostenere la sua stima. Questa prova include qualsiasi incertezza che si annida nei dati appena analizzati dalla rete neurale o la sua autoconsapevolezza di quanto sia sicuro della propria decisione. Amini e il suo team hanno testato il metodo di regressione probatoria profonda addestrando l'intelligenza artificiale a stimare la profondità di ciascun pixel in un'immagine. La percezione della profondità potrebbe significare vita o morte in un intervento chirurgico che deve rimuovere un tumore che potrebbe trovarsi in profondità all'interno del corpo e altrimenti difficile da vedere.

L'intelligenza artificiale era per lo più accurata, ma ha fatto un casino una volta si nutriva di immagini più difficili da ricordare. Almeno c'era una cosa su cui era coerente: di fronte a immagini che gli davano difficoltà, avrebbe informato il team della sua incertezza senza fallo. Il suo determinato margine di errore può almeno insegnare ai ricercatori come migliorare quel modello. La sua capacità di riconoscere le immagini che sono state Photoshoppate apre anche la possibilità di riconoscere i deepfake. Gli umani devono solo essere consapevoli che questo cervello robotico è ancora fallibile e non possiamo fidarci di esso più di quanto possa fidarsi di se stesso.

Riteniamo che siano necessarie ulteriori indagini per scoprire modi alternativi per rimuovere prove non fuorvianti, Amini ha detto .

Ciò significa che l'intelligenza artificiale che può pensare usando una profonda regressione probatoria è abbastanza affidabile purché il risultato di una risposta sbagliata non sia letale.